Инженерные решения в современных ЦОД компании Google

Красивые фото ЦОД Google никого не оставят равнодушным, и будут крайне интересны работникам сферы высоких технологий. Профессионалам в области дизайна ЦОД стоит тщательно их изучить. Я давно заметил, что любые технические решения, демонстрируемые Google широкой публике, относятся к прошлому поколению, или и того раньше. Однако, команда Google знает свое дело, так что даже устаревшие решения заслуживают внимания.

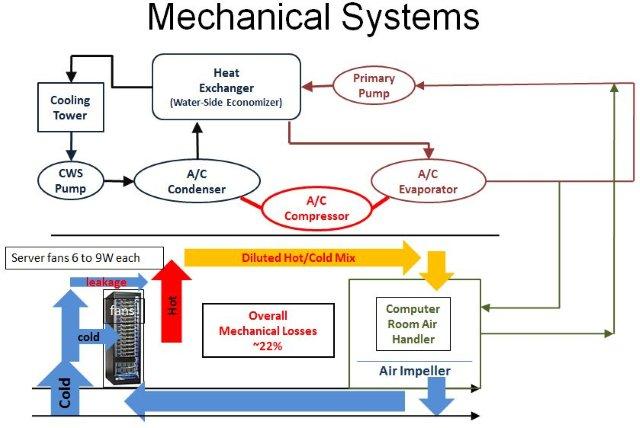

Опубликованная ранее серия фотографий "Где живет интернет" интересна тем, что на них представлены новейшие разработки Google, применяемые в современных дата-центрах компании. Фотографии не везде сопровождаются пояснениями, однако, как гласит старая пословица, одна картинка стоит тысячи слов. "Представленные механические решения показались мне крайне интересными, и я подробно остановлюсь на них, но сначала обратимся к традиционной схеме механических систем ЦОД, с которой будем сравнивать подход, используемый Google" - говорит Джеймс Гамильтон. Дальнейший текст - выдержки из его блога.

"У традиционной схемы ЦОД есть множество недостатков, и самый очевидный из них заключается в том, что схема, разработанная сорок лет назад, явно устарела и может быть существенно модернизирована. Заметные недостатки традиционного проекта ЦОД:

- нет изоляции холодных и горячих участков, что приводит к воздушным утечкам и к смешению горячего и холодного воздуха,

- между шкафными кондиционерами и охлаждаемыми серверами воздух перемещается на большое расстояние, и это перемещение воздуха дорого обходится,

- система охлаждения является закрытой, происходит охлаждение нагретого воздуха и его рециркуляция вместо выброса за пределы здания и забора свежего воздуха с последующим охлаждением в случае необходимости.

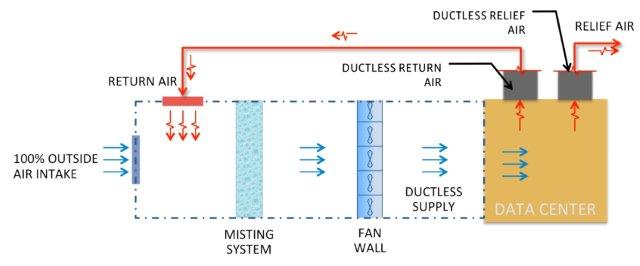

Схема, примененная в дата-центре Prineville Oregon компании Facebook, является прекрасным примером современного ЦОД, устраняющего перечисленные выше недостатки."

"Мне очень нравится этот объект. Применяемая схема позволяет полностью исключить систему водяного охлаждения, не использует чиллеры (достаточно дорогое оборудование), реализует полную изоляцию горячих коридоров, применяет испарительное охлаждение наружным воздухом и использует целое здание в качестве огромного, высокоэффективного воздуховода."

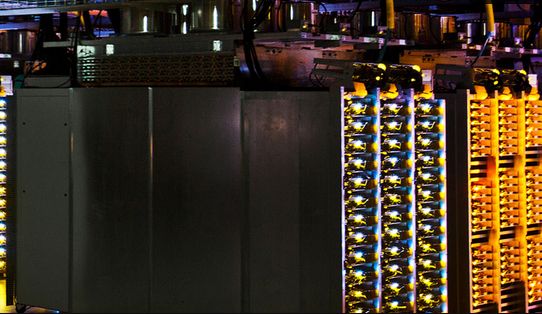

Давайте взглянем на дата-центр Google Council Bluffs Iowa:

"Как видно из фотографии, серверное помещение представляет собой огромную единую комнату, не разделенную на отсеки. Конструкция предусматривает изоляцию горячих участков, что позволяет почти полностью устранить утечку воздуха вокруг серверов и серверных стоек. Весь охлажденный воздух проходит через серверы, нагретый воздух направляется в теплообменник. Система изоляции воздушных потоков позволяет существенно повысить эффективность охлаждения и является вторым по значимости решением после воздушных экономайзеров. Применение воздушных экономайзеров предполагает использование наружного воздуха для охлаждения серверов, вместо охлаждения нагретого отработанного воздуха до необходимой рабочей температуры (см. указанную выше схему Facebook, предусматривающую использование всего здания в качестве воздуховода и применение воздушных экономайзеров)."

"Судя по фотографии площадки Council Bluffs, Google выбрала совершенно другой подход. Вместо отказа от применения системы водяного охлаждения и использования всего здания в качестве воздуховода, в компании решили сохранить водяное охлаждение и сделать его как можно более эффективным, используя некоторые преимущества, предоставляемые подобными системами. На фотографии дата-центра Google Hamina Finland можно заметить теплообменник с множеством катушек, расположенный над системой изоляции горячих коридоров."

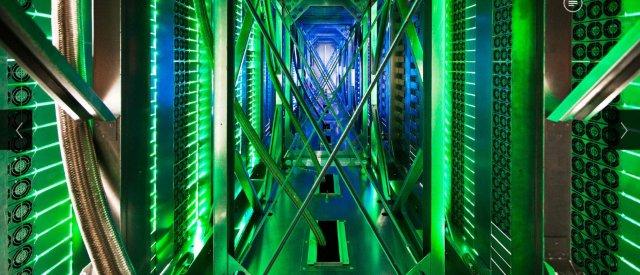

"Следующая фотография, на которой представлен дата-центр Mayes County, позволяет заглянуть внутрь горячих коридоров. Видно, что охлажденная вода в них поступает по гибким шлангам в стальной оплетке. Данные шланги подают холодную воду в расположенные над горячими коридорами теплообменники, которые охлаждают отработанный воздух прежде, чем тот будет выпущен над серверными стойками."

"Одно из ключевых преимуществ водяного охлаждения заключается в том, что для заданного уровня теплоемкости перемещение воды обходится дешевле, чем воздуха. В Google используют данное преимущество за счет подачи воды непосредственно в серверную стойку. Замечательный подход, но это не первый случай применения подобного решения в отрасли. В схеме IBM iDataPlex вода подавалась непосредственно в заднюю часть стойки, схожее решение применялось также во многих системах высокопроизводительных компьютерных вычислений."

"Я не вижу преимуществ вытяжных труб над теплообменниками. Мне кажется, что любые преимущества, связанные с эффектом воздушной тяги через вытяжные трубы, будут компенсироваться потерями, связанными с использованием пассивных вытяжных труб вместо активных теплообменников."

"Подача воды непосредственно в серверную стойку является эффективным решением, однако, я все же предпочитаю воздушные экономайзеры. Любая система, выбрасывающая отработанный воздух за пределы здания и осуществляющая забор наружного воздуха (по мере необходимости) для охлаждения серверов является крайне эффективной (см. диаграмму вверху страницы). Я предпочитаю системы, использующие наружный воздух, однако, по мере роста плотности расположения серверов, мы рано или поздно придем к ситуации, когда придется использовать водяное охлаждение. И тогда придется либо пропускать охлаждающие трубы рядом с серверами, как поступает Google, либо применять прямое водяное охлаждение, использовавшееся в мейнфреймах IBM в 80х годах. Примером качественной современной системы прямого водяного охлаждения может служить подход, реализуемый Green Revolution Cooling, в котором предполагается полное погружение серверов в ванну из охлажденного масла."

"Снимаю шляпу перед Google за публикацию крайне информативной серии фотографий принадлежащих компании ЦОД. Прекрасные фотографии, и замечательные инженерные решения. Хорошая работа!"

Дополнительные материалы

Оставить комментарий