Энергоэффективные системы охлаждения действующих и проектируемых ЦОД в России и зарубежом

Рынок систем кондиционирования для ЦОД особенный. С одной стороны, он весьма узкий, с другой стороны, очень прогрессивный. Благодаря обилию теплоизбытков в дата-центрах у специалистов по системам кондиционирования есть простор для фантазии – куда именно отводить тепло, как сделать это эффективно и как его потом использовать. Предлагаем вашему вниманию обзор самых интересных и перспективных решений по охлаждению ЦОД, которые уже нашли место в жизни, а вскоре станут основой для новых, ещё более прогрессивных проектов.

По разным данным мощность центров обработки данных в мире составляет от 3 до 5% от всей потребляемой человечеством электроэнергии. В то же время классические парокомпрессионные системы охлаждения потребляют около 30% от мощности ЦОД. Таким образом, энергоёмкость систем кондиционирования ЦОД – 1% всей мировой электроэнергии – цифра весьма значительная, если учесть что это лишь одна инженерная система одной единственной отрасли жизнедеятельности человека. Этим и объясняется стремление сократить мощность холодильных систем до минимума.

Среди энергоэффективных технологий охлаждения крупных ЦОД на сегодняшний день наибольшее распространение получили решения на базе свободного охлаждения. Ни одно строительство крупного ЦОД не обходится без предварительного технико-экономического анализа, в рамках которого рассматриваются различные варианты системы кондиционирования. И всё чаще заказчики склоняются к применению фрикулинга взамен фреоновых кондиционеров.

Мировые гении энергоэффективности

Стремление компании Google к максимальной энергоэффективности известно во всем мире. Последние 10-15 лет едва ли не каждый новый центр обработки данных Google – это масштабный проект, находящийся на пике развития отрасли ЦОДостроения. А опубликованная несколько лет назад серия фотографий «Там, где живёт интернет» (одна из них представлена на рисунке 1) вызвала немалый интерес специалистов всех инженерных систем. Помимо Google на мировой арене центров обработки данных блистают Facebook, Apple, Microsoft, а также Amazon, Yahoo!, IBM и другие.

Рисунок 1. Система охлаждения ЦОД Google в Даллесе (штат Орегон, США)

Компания Google одной из первых осознала, что на инженерную инфраструктуру ЦОД, а особенно на систему охлаждения, тратится не позволительно много энергии. И принялась за эксперименты.

Поначалу проекты предусматривали прямое и косвенное охлаждение серверов наружным воздухом. После этого в компании перешли к рассмотрению идеи сброса тепла в землю, моря и океаны. Так, например, появился дата-центр Google недалеко от города Хамина (Финляндия). Он построен на базе бывшей бумажной фабрики на берегу Финского залива, за счёт которого и охлаждаются машинные залы ЦОД.

Ожидаемый к строительству ЦОД Google в Южной Каролине (США) планирует использовать для охлаждения подземные воды. По оценкам компании, им потребуется выкачивать 5,7 миллионов литров воды в день из водоносного горизонта. Проект проходит стадию согласования с местными властями.

Самые последние разработки Google явно свидетельствуют о том, что не за горами эпоха жидкостного охлаждения ЦОД. В частности, новейшее серверное оборудование для выполнения расчётов в рамках технологий искусственного интеллекта имеет колоссальную удельную тепловую мощность (мощность на единицу объёма). Она примерно в 8 раз выше мощности серверного оборудования, которое могло бы охлаждаться воздухом. Жидкостное охлаждение подразумевает непосредственный контакт вычислительных устройств и диэлектрического теплоносителя, что позволяет существенно улучшить теплообмен и повысить отводимую мощность.

Наконец, ещё одна идея от Google – плавучие ЦОД. В сентябре 2016 года компания получила патент на это изобретение. Машинные залы плавучих ЦОД будут расположены на барже. Система охлаждения – двухконтурная. Внутренний контур подготовленного холодоносителя будет охлаждаться за счёт внешнего контура морской воды. Но главная особенность плавучего дата-центра – способ его приведения в движения. Для этого к барже будут прикреплены огромные воздушные змеи, которые за счёт ветра, то есть без топлива и электроэнергии, смогут управлять скоростью и направлением движения дата-центра.

Идеей размещения центра обработки в море прониклись и в компании Microsoft. Причём в прямом смысле в море – на глубине 37,5 метров, и не просто прониклись, а уже реализовали свои планы. 5 июня 2018 года было объявлено о том, что 12-метровая капсула погружена в Северное море возле Оркнейских островов (Шотландия) на 5 лет. Внутри капсулы расположено 12 стоек, максимальная мощность дата-центра составляет 240 киловатт.

Конструкция затопленного ЦОД подразумевает хорошую теплопередачу и быстрое рассеивание тепла в морской воде. Негодования экологов об увеличении температуры моря были отвергнуты достаточно быстро: капсула может нагреть воду вокруг себя, но в масштабах всего моря нагрев не превысит нескольких миллиардных долей градуса.

Подводный ЦОД не имеет эксплуатирующего персонала и полностью управляется с земли. Чтобы избежать коррозии внутренних элементов и исключить негативное воздействие кислорода и водяного пара внутри капсулы находится только азот. Инженеры Microsoft надеются, что предпринятые меры безопасности исключат риск поломок внутри ЦОД. В случае положительного исхода эксперимента в будущем планируется затапливать дата-центры, состоящие сразу из пяти таких капсул, то есть мощностью более мегаватта.

Примером использования холода глубинных вод и горных недр является ЦОД Green Mountain DC1-Stavanger. Он расположен внутри скал одного из норвежских фьордов, в месте бывшего хранилища боеприпасов НАТО, законсервированного со времён холодной войны.

Источником холода для Green Mountain DC1-Stavanger служит вода из глубоководного фьорда. На глубине 75 метров и ниже температура воды стабильна и составляет +8°С. Водозабор осуществляется с глубины 100 метров. Холодная вода подаётся в теплообменник, где охлаждает внутренний контур подготовленного холодоносителя, после чего сбрасывается обратно в залив. В машинном зале ЦОД установлены внутрирядные кондиционеры, охлаждающие воздух за счёт холодоносителя.

Энергоэффективные дата-центры Яндекса

Одним из лидеров по реализации энергоэффективных систем охлаждения ЦОД в России является компания Яндекс. Она прошла путь развития собственной ИТ-инфраструктуры от одного сервера до десятка дата-центров, причём со временем Яндекс «научился» строить свои собственные центры обработки данных – со смелыми решениями и высокой эффективностью.

Первый опыт Яндекса по внедрению энергосберегающих технологий относится к 2008 году, когда компания построила ЦОД в подмосковной Ивантеевке на базе системы FFC – Full FreeCooling. Данная технология представляет собой косвенный фрикулинг с адиабатикой, а перенос тепла от внутреннего воздуха наружному выполняется при помощи большого роторного теплообменника.

При наружных температурах ниже +22°С серверное оборудование охлаждается исключительно за счёт наружного воздуха. При более высоких наружных температурах задействуется дополнительное охлаждающее оборудование. Внутренний воздух имеет температуру +37°С в горячей зоне и +24°С на выходе из системы охлаждения.

На тот момент технологии свободного охлаждения ещё не были протестированы в России, реального опыта проектирования и эксплуатации фактически не было. Поэтому компания Яндекс сперва запустила первую очередь дата-центра в Ивантеевке (в 2008 году), после чего занялась сбором данных и их обработкой. Только после этого в 2011 году в строй была введена вторая очередь объекта.

Как показал опыт, годовое энергопотребление системы свободного охлаждения оказалось вдвое ниже аналога на традиционных фреоновых кондиционерах. Сходное решение на базе технологии Full FreeCooling Яндекс применил и в своём очередном центре обработки данных в городе Сасово Рязанской области, запущенном в 2014 году (см. рисунок 2).

Рисунок 2. Вентиляционные установки в центрах обработки данных компании Яндекс

Следующая ступень развития идеологии энергоэффективного охлаждения от Яндекс – переход на прямой фрикулинг. И здесь внимания заслуживает дата-центр Яндекса в Финляндии в городке Мянтсяля, первая очередь которого была запущена в эксплуатацию в 2015 году. Собственно, одна из причин выбора именно этой локации – прохладный климат и возможность использования круглогодичного прямого фрикулинга.

На тот момент у Яндекса уже был многолетний опыт эксплуатации дата-центров в Ивантеевке и в Сасово и, как отмечают в компании, это позволило для каждого нового проекта делать обоснованный выбор на базе накопленной информации, а не на основе маркетинговых данных из каталога. В финском центре обработки данных было принято решение полностью отказаться от дорогих и энергоёмких традиционных кондиционеров в пользу 100-процентного режима свободного охлаждения. Коэффициент эффективности ЦОД PUE составил 1,1.

Итак, в ЦОД Яндекса в городе Мянтсяля наружный воздух проходит через секции фильтров, охлаждает серверное оборудование и выбрасывается обратно на улицу. В зимнее время вытяжной воздух частично рециркулируется для нагрева холодного уличного воздуха. В особо жаркие летние дни приточный воздух дополнительно охлаждается за счёт распыления воды. Фактически это система прямого фрикулинга с адиабатикой (см. рисунок 3). Раньше такие идеи лишь обсуждались в кулуарах, но на практике распылять воду в воздух, который далее попадает в дорогостоящее вычислительное оборудование ЦОД, никто не решался.

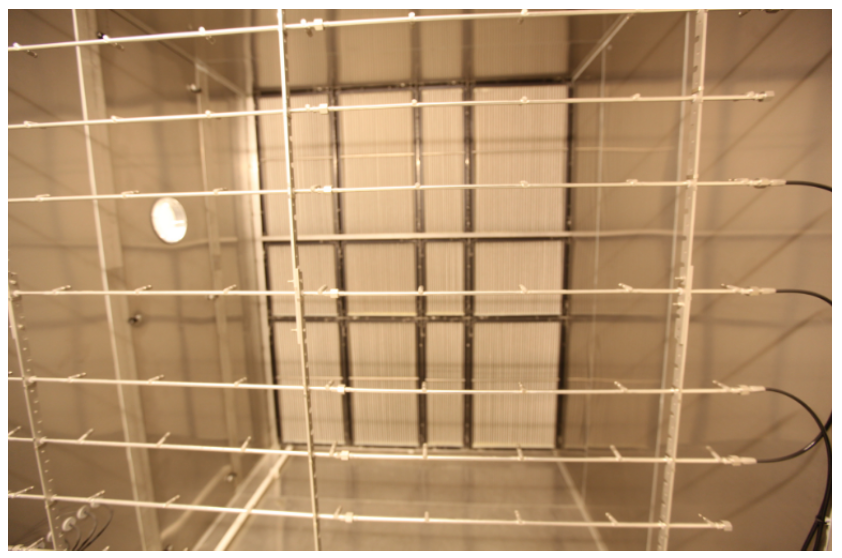

Рисунок 3. Камера адиабатного увлажнения воздуха и каплеуловители в установке прямого фрикулинга ЦОД компании Яндекс в Финляндии (фото взято из блога Яндекса на портале HabraHabr)

Система охлаждения ЦОД занимает целый этаж, на котором помещения играют роль воздуховодов. Высота нагнетающего вентилятора достигает одного метра и, чтобы перекрыть ими всё сечение воздуховода, они устанавливаются матрицей – по три в высоту и ещё больше – в ширину. В одной из венткамер секция фильтрации является её стеной. Размеры регулирующих заслонок также измеряются метрами и образуют матрицу на стене.

Горячий коридор машинного зала изолирован и представляет собой большой воздуховод для отвода нагретого воздуха на улицу. Но – не совсем на улицу. Ещё одна «фишка» финского дата-центра – использование вытяжного горячего воздуха для нагрева теплоносителя и его передачи в теплосеть города Мянтсяля.

Но для отопления района теплоноситель с температурой порядка 30°С не подойдёт. С целью повышения температуры теплоносителя до необходимой температуры (55-60°С) для использования в системе отопления использованы тепловые насосы. Таким образом, дата-центр, который «ушёл» от энергоёмких фреоновых кондиционеров мало того, что сэкономил на охлаждении, так ещё и обогрел близлежащий городок.

Стоит отметить, что в машинном зале ЦОД фигурирует пусть и очищенный, но наружный воздух, дополнительно увлажнённый в жаркие дни. С целью сохранения работоспособности серверного оборудования при более холодных и теплых температурах компания Яндекс провела соответствующие исследования и модернизацию этого оборудования.

Кстати, технические характеристики некоторого серверного оборудования говорят о его работоспособности при температурах до +40°С. Далее требовалось обеспечить настолько качественный продув помещения, чтобы воздух в замкнутом пространстве не прогрелся до такой температуры.

Результатом расчётов и исследований стала уверенность в том, что набитый серверами машинный зал сможет работать на прямом фрикулинге не только в северных регионах, но и в климате центральной России. Очередным объектом компании стал ЦОД во Владимире в микрорайоне Энергетик. Первая очередь владимирского дата-центра была запущена в сентябре 2017 года. Предварительный PUE этого ЦОД – 1,07, что является самым лучшим показателем в России и одним из лучших в мире.

Основой охлаждения ЦОД Яндекс во Владимире также является технология свободного охлаждения. Вырабатываемое тепло может быть направлено на благо города, например, на обогрев теплиц для выращивания овощей. Другие возможности применения низкопотенциального тепла рассматриваются в настоящий момент.

Центры обработки данных Сбербанка

Путь экспериментов, накопления информации и анализа статистических данных прошла и компания Сбербанк. Первым и на тот момент самым мощным проектом стал ЦОД Сбербанка «Южный порт», открытый в 2011 году. Общая его площадь составила 16 тысяч квадратных метров, площадь машинных залов – 5 тысяч квадратных метров, что являлось максимальной величиной для дата-центров банковского сектора в Европе.

Кондиционирование ЦОД «Южный порт» осуществлялось по принципу свободного охлаждения с использованием установок Plate Exchanger Air Handling Units – пластинчатых теплообменников типа «воздух-воздух», выпущенных специально для данного проекта. Каждый теплообменник имеет расчётную холодопроизводительность 550 киловатт, весь ЦОД обслуживают 28 установок. В жаркие дни дополнительно включается адиабатное охлаждение воздуха. Расчётный PUE не превышает 1,3.

Установки свободного охлаждения установлены на кровле здания. В машинные залы охлаждённый воздух подаётся посредством воздуховодов, спускающихся с кровли на нужный этаж по фасаду здания.

Кстати, по этому же принципу чуть позже строился московский ЦОД компании DataPro. В качестве установок свободного охлаждения были приняты агрегаты EcoBreeze компании Schneider Electric мощностью 350 киловатт каждый. Рекламные проспекты производителя предусматривали их наземную установку и горизонтальный ввод воздуховодов в машинный зал ЦОД. Однако на практике было принято решение подобно «Южному порту»: установить EcoBreeze на кровле ЦОД и соединить их с машинным залом воздуховодами, проходящими по фасаду здания.

Отработав технологию свободного охлаждения на первом дата-центре, в конце 2017 года Сбербанк открыл второй, ещё более мощный объект в Сколково. На этот раз система охлаждения была выполнена по схеме прямого фрикулинга и имела ряд инноваций.

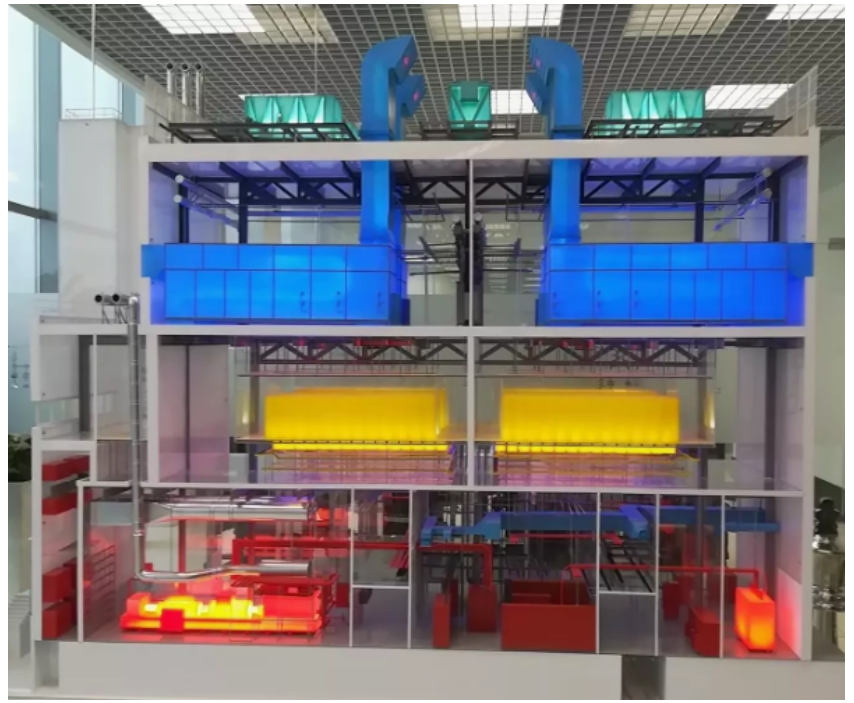

Общая площадь ЦОД Сбербанка в Сколково 33 тысячи квадратных метра и включает в себя 5 модулей по 4 машинных зала. Охлаждение осуществляется вентиляционными установками (см. рисунок 4) и работает до 330 дней в году в режиме свободного охлаждения. На случай жарких дней в работу включаются дополнительные системы фреонового охлаждения. Отводимое фрикулингом тепло идёт на нужды отопления офисной части здания.

Рисунок 4. Разрез ЦОД Сбербанка в Сколково. Мощные вентиляционные установки прямого фрикулинга (синие) расположены на третьем этаже и охлаждают серверные стойки (жёлтые) в машинных залах второго этажа.

Интересно отметить, что охлаждение ЦОД Сбербанка в Сколково оснащено элементами искусственного интеллекта. В частности, объект имеет собственную метеостанцию, а программное обеспечение анализирует прогноз погоды и запасает холод на случай приближающейся жары. По данным Сбербанка экономия за счёт грамотного управления системой охлаждения ЦОД составляет до 100 миллионов рублей в год на электроэнергии и ещё 5 миллионов рублей в год на отоплении офисной части объекта.

Опыт других компаний

Системный интегратор КРОК использовал уже несколько подходов энергосбережения для своих заказчиков. Например, геотермальное охлаждение базовых станций. Температура земли на глубине от 30 до 100 метров составляет 6-10°С в течение целого года. Зимой скважины могут быть использованы тепловым насосом для обогрева помещений, летом – для сброса тепла от работающего серверного оборудования. Ориентировочный теплосъём составляет 50 Вт на один метр длины геозонда. Мощность базовых станций относительно невелика, поэтому проект обошёлся малыми раскопками, но для крупных ЦОД, безусловно, потребовалось бы существенно большая длина подземных труб.

Другой пример – для одного из центров обработки данных в Сибири была реализована система подогрева воды для ТЭЦ, от которой, собственно, и запитан ЦОД. ТЭЦ получала воду из реки с температурой от 0 до +15°С с последующим догревом до +25°С. По факту реализации проекта частично этот нагрев был обеспечен теплом, которое отводилось из машинного зала ЦОД.

И ещё один пример – самый мощный суперкомпьютер России «Ломоносов-2», установленный в МГУ им. М. В. Ломоносова, имеет водяное охлаждение. Теплоноситель подводится в радиаторы, расположенные в непосредственной близости от вычислительных микросхем. При этом используются специальные трубки с бескапельными разъёмами. В процессе охлаждения температура теплоносителя достигает 44°С и круглый год охлаждается за счёт наружного воздуха в драйкулерах.

Использование тепла ЦОД

С годами на рынке ЦОД вырисовывается явная тенденция: тепло, выделяемое ЦОД, рассматривается не как что-то вредное, от чего следует избавиться, а как что-то полезное, что может послужить на пользу человеку. Рассмотренный дата-центр Яндекса с отоплением прилегающего города – лучший тому пример.

В целом же, наиболее простым является решение об использовании тепла ЦОД для собственных нужд объекта. Такой подход не требует взаимосвязи с государством и свободен от бюрократических преград. К каждому крупному дата-центру прилегает собственная офисная зона, и именно она может быть обеспечена отоплением и горячей водой за счёт тепловой энергии дата-центра.

Таких проектов ещё нет в России, но они весьма распросранены на западе. Например, система жидкостного охлаждения Iceotope для суперкомпьютера Хаддерсфилдского университета Великобритании отдаёт тепло в систему отопления самого университета. Английская компания WSP Group направила тепло от собственного коммерческого дата-центра для подогрева воды в близлежащем бассейне. Существуют проекты обогрева теплиц за счёт тепла ЦОД. Ещё более популярны решения по нагреву приточного воздуха для вентиляции прилегающих офисных зданий.

В сфере утилизации тепла от центров обработки данных есть за что бороться. По данным компании DCD Intelligence, совокупная мощность всех дата-центров мира сравнима с энергопотреблением Великобритании. Дата-центры одного только Евросоюза запросто обогреют город-миллионник. Осознавая масштаб потенциальной выгоды, специалисты уже сегодня разрабатывают и тестируют различные решения по утилизации тепла.

Страной-лидером по масштабности «зелёных» технологий в сфере ЦОД следует признать, пожалуй, Нидерланды. Около 90% дата-центров этой страны уже использую ветряные электростанции для энергоснабжения ЦОД. Новый виток развития ожидается в ближайшем будущем: в Нидерландах планируется создать отходящие от крупных дата-центров тепловые сети для отопления близ лежащих населённых пунктов.

Немалый потенциал использования тепла дата-центров имеют и российские объекты. Однако мировой опыт показывает – такие инициативы не по плечу одному или нескольким инвесторам. Основную роль в развитии альтернативной энергетики и систем утилизации тепла должно сыграть государство путём введения налоговых льгот, запуска стимулирующих правительственных программ, возможности коммерческого использования излишков тепла и электроэнергии. Нет сомнений, что подобные подвижки в законодательной базе существенно ускорят темпы развития энергоэффективных технологий для охлаждения ЦОД в России.

Дополнительные материалы

Оставить комментарий